Сейчас 127 заметки.

Ограничения для продвижения: различия между версиями

Adkrasyuk (обсуждение | вклад) |

Adkrasyuk (обсуждение | вклад) |

||

| Строка 599: | Строка 599: | ||

(которые на самом деле не предлагает автомобильная компания), можно | (которые на самом деле не предлагает автомобильная компания), можно | ||

«заработать» пессимизацию. | «заработать» пессимизацию. | ||

| + | |||

| + | |||

| + | == Большое количество запросов для продвижения == | ||

| + | |||

| + | Семантическое ядро, состоящее из нескольких сотен или даже тысяч | ||

| + | запросов, значительно увеличивает сроки продвижения сайта. Вот основные | ||

| + | причины: | ||

| + | *'''Закупка ссылок'''. Роботы поисковых систем негативно относятся к быстрому росту ссылочной массы, поэтому закупка ссылок не должна быть агрессивной. Чтобы набрать достаточное их количество для каждого запроса, потребуется значительно больше времени, чем при работе с семантическим ядром, состоящим, например, из 20-30 запросов. | ||

| + | *'''Написание и корректировка текста для продвигаемых страниц'''. Чем больше запросов, тем больше страниц с уникальным и полезным контентом под них нужно создать, что скажется на сроках оптимизации сайта. | ||

| + | *'''Внутренняя перелинковка'''. Потребуется много времени, чтобы корректно, в полном объёме и для необходимого количества запросов сделать перелинковку страниц сайта. | ||

| + | *'''Анализ конкурентов'''. При большом семантическом ядре необходимо | ||

| + | определить конкурентность большого числа запросов, и проводить такой | ||

| + | анализ надо будет после каждого апдейта. | ||

| + | |||

| + | |||

| + | == Большое количество ВЧ запросов == | ||

| + | |||

| + | Не стоит ожидать значительного увеличения трафика в начале продвижения, | ||

| + | если семантическое ядро состоит только из высокочастотных (ВЧ) и не | ||

| + | содержит низкочастотных (НЧ) запросов. Это большая ошибка, поскольку | ||

| + | обычно НЧ запросы гораздо быстрее попадают в ТОП поисковой выдачи и | ||

| + | практически сразу начинают приводить первых посетителей. | ||

| + | |||

| + | Среди основных недостатков продвижения большого количества | ||

| + | высокочастотных запросов можно выделить: | ||

| + | *'''Приток нецелевых посетителей'''. Высокочастотные запросы не являются точными. Попав на сайт из результатов выдачи по такому запросу и не найдя нужной информации, пользователь возвращается обратно в поиск. Следовательно, значительная часть денег на ВЧ продвижение будет потрачена зря, а у вашего сайта ухудшится статистика поведенческих факторов за счет того, что увеличится показатель отказов. | ||

| + | *'''Высокая конкуренция'''. Высокочастотные запросы часто являются высококонкурентными, продвижение которых требует больших денежных вложений и сил на последующее удержание позиций. | ||

| + | *'''Ограничения в выборе продвигаемой страницы'''. Как правило, для продвижения под высокочастотные запросы выбирают главную страницу сайта (ее вес обычно выше из-за естественной ссылочной массы и | ||

| + | организованной перелинковки). | ||

Версия 21:55, 14 марта 2013

В предыдущей главе мы подробно рассмотрели, как происходит ранжирование сайтов в Яндексе. Эти знания помогут вам понять, как можно влиять на позиции сайта в выдаче поисковой системы. Однако прежде чем начинать продвижение, необходимо ознакомиться и с возможными сложностями, которые иногда возникают на пути к ТОПу.

В третьей главе мы рассмотрим ограничения, мешающие продвижению, а также наиболее сложные и распространенные фильтры, которые применяются поисковыми системами Яндекс и Google, чтобы исключить из поисковой выдачи или понизить в ней позиции сайтов, не соответствующих стандартам качества Яндекс и Google, то есть таких ресурсов, которые не являются удобными, информативными и полезными.

Внимательно изучив эту главу, вы сможете избежать ситуаций, когда поисковые системы удаляют сайт из поисковой выдачи или понижают его позиции.

Фильтры поисковой системы Яндекс

Фильтры — это алгоритмы, используемые поисковой системой для определения сайтов, которые применяют искусственные методы повышения позиций в выдаче (накрутки факторов ранжирования).

В случае обнаружения нарушений, поисковая система подвергает такой сайт санкциям: пессимизации (занижению позиции в поисковой выдаче) или удалению из выдачи.

Наличие накруток факторов ранжирования поисковая система определяет по превышению порога естественности, то есть допустимых показателей. Порог естественности вычисляется Яндексом для каждого ресурса индивидуально на основе сложной формулы.

К примеру, поисковый робот видит молодой сайт, на который ссылаются сотни других ресурсов. Вроде бы надо поднять этот сайт в поисковой выдаче, раз на него так часто ссылаются, значит — ресурс содержит полезную для пользователей информацию. Однако обычно такое количество внешних ссылок сайт «зарабатывает» только через 2-3 года существования, а у новичка возраст — 3 месяца. Поисковая система делает вывод, что эти внешние ссылки получены не естественным путем, а накруткой. И поэтому позиции сайта либо остаются неизменными и просто не растут, либо понижаются.

Что поисковая система считает накруткой факторов ранжирования?

- неестественное поведение для определенной тематики;

- одинаковый сценарий поведения на сайте;

- резкие и необоснованные всплески посещаемости и пр.

- перенасыщение страниц ключевыми словами;

- много внешних ссылок (>5 на странице);

- чрезмерное использование в тексте выделений жирным шрифтом и курсивом.

Понять, что на ресурс наложен фильтр, можно, проанализировав изменения поисковой выдачи. Если после очередного апдейта резко ухудшилось положение сайта в выдаче или на протяжении уже нескольких месяцев он не поднимается выше 100-й позиции, то это является верным признаком наложения санкций. Подтверждение этому можно получить в службе поддержки Яндекса. В большинстве случаев в ответном письме будет указана возможная причина наложения фильтра и ссылка на рекомендации по ее устранению.

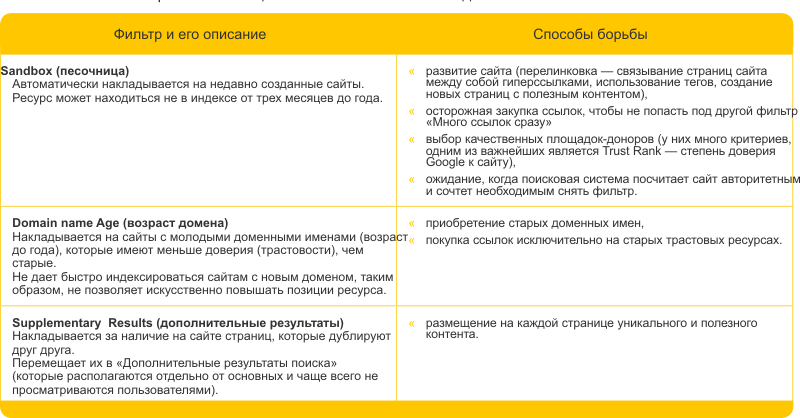

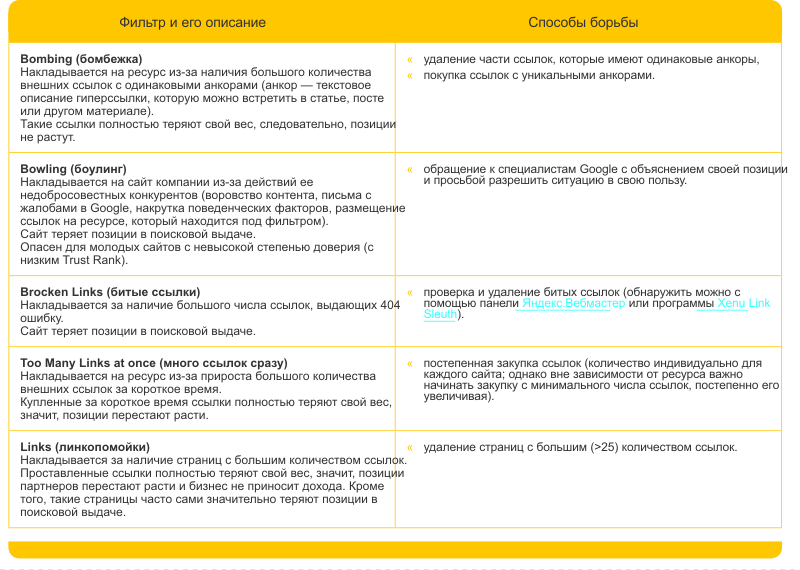

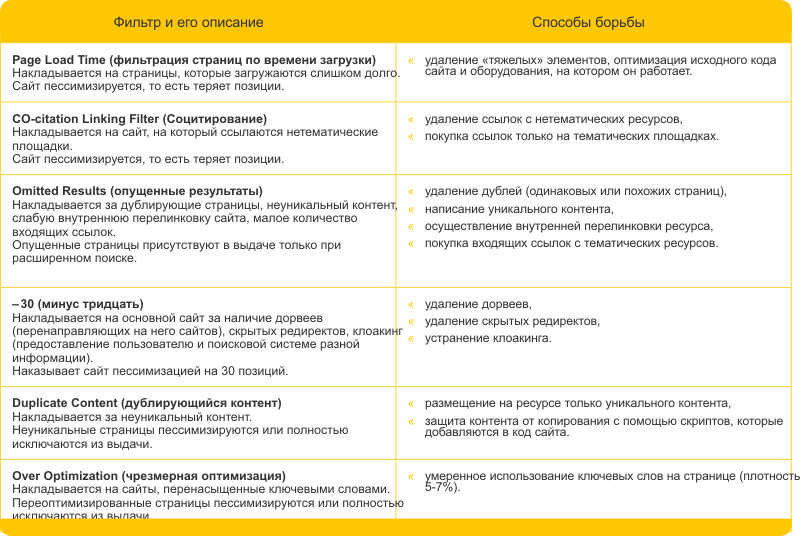

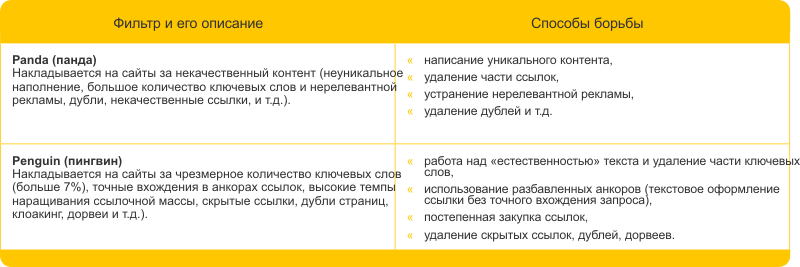

Существует несколько типов фильтров. Под одни попадают нарушения, связанные со ссылочной массой (ссылками, ведущими на сайт), под другие — с текстами, под третьи — с поведенческими факторами, четвертые пессимизируют сайт из-за технических ограничений. Рассмотрим каждый фильтр Яндекса подробнее.

- АГС

АГС — это фильтр, запрещающий индексацию неинформативных интернет-ресурсов, бесполезных для пользователя. Фильтр «АГС» исключает влияние таких сайтов на результаты ранжирования. Под фильтр АГС чаще всего попадают сайты-сателлиты — сайты, созданные не для людей, а в качестве вспомогательных средств для продвижения основного ресурса. Они часто представляют собой несколько страниц со ссылками, ведущими на продвигаемый ресурс. Основные признаки сайта-сателлита:

- автоматически сгенерированный контент;

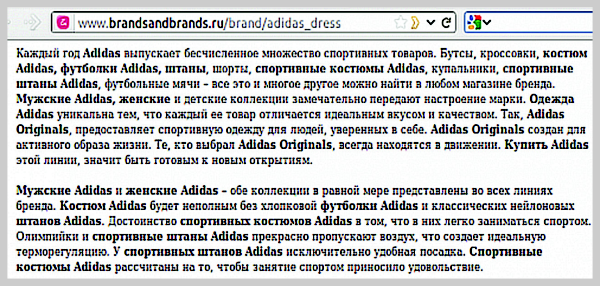

Рис.1 Пример контента, сгенерированного автоматически

- неуникальный контент (скопированный с других ресурсов);

- наличие разделов, не связанных с тематикой сайта (например, на сайте автомобилей присутствует раздел «Комнатные растения»);

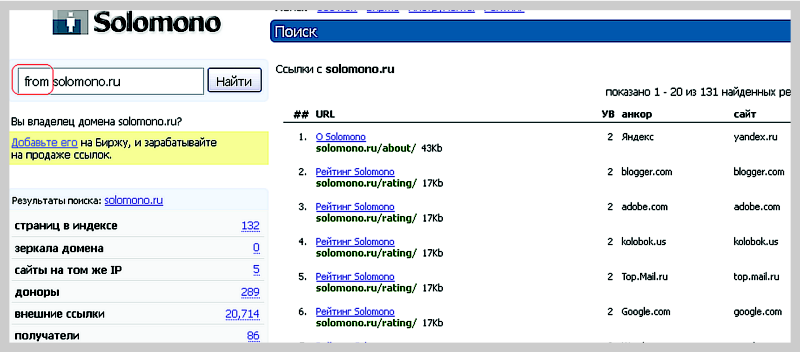

- большое количество исходящих ссылок (можно проверить с помощью сервиса solomono.ru, который предоставляет подробную информацию по ссылкам);

Рис.2 Интерфейс Solomono - сервиса для отслеживания исходящих ссылок

- большой процент неинформативных страниц (таких, которые помимо навигации содержат не более 100 символов текста).

Наложение фильтра АГС выражается в резком выпадении страниц сайта из индекса поисковой системы. Если большая их часть долго не индексируется, это повод провести анализ и выяснить, не имеет ли ресурс признаков сателлита.

Под фильтр АГС может попасть и обычный сайт, который не был намеренно переоптимизирован. Как избежать этого:

- следите за качеством контента: не размещайте на своем ресурсе страниц, на которых нет полезной и интересной для пользователя информации или ее слишком мало. Оптимальным объемом контента seo-специалисты считают от 300 до 3000 слов, плотность ключевых слов не должна превышаеть 7%. Все предложения и словосочетания должны быть выстроены в соответствии с правилами русского языка и легко восприниматься людьми;

- не копируйте контент с других сайтов или со своих же страниц, созданных ранее;

- модерируйте исходящие ссылки: если вдруг неизвестные начали размещать в комментариях на вашем сайте ссылки — их необходимо удалять, иначе ваш сайт сочтут линкопомойкой — ресурсом, на который неконтролируемо «сваливаются» входящие ссылки для увеличения веса сайта. Существует даже специальный фильтр, блокирующий активность линкопомоек. Подробнее об этом будет рассказано ниже.

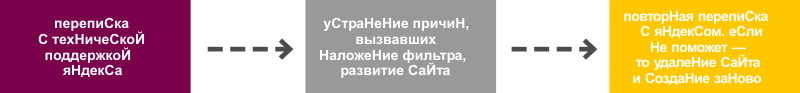

Порядок действий по снятию фильтра АГС:

- «Ты последний»

«Ты последний» — фильтр, который накладывается на конкретную страницу за неуникальный, неинформативный и бесполезный контент. Такая страница помещается на последнее место в поисковой выдаче.

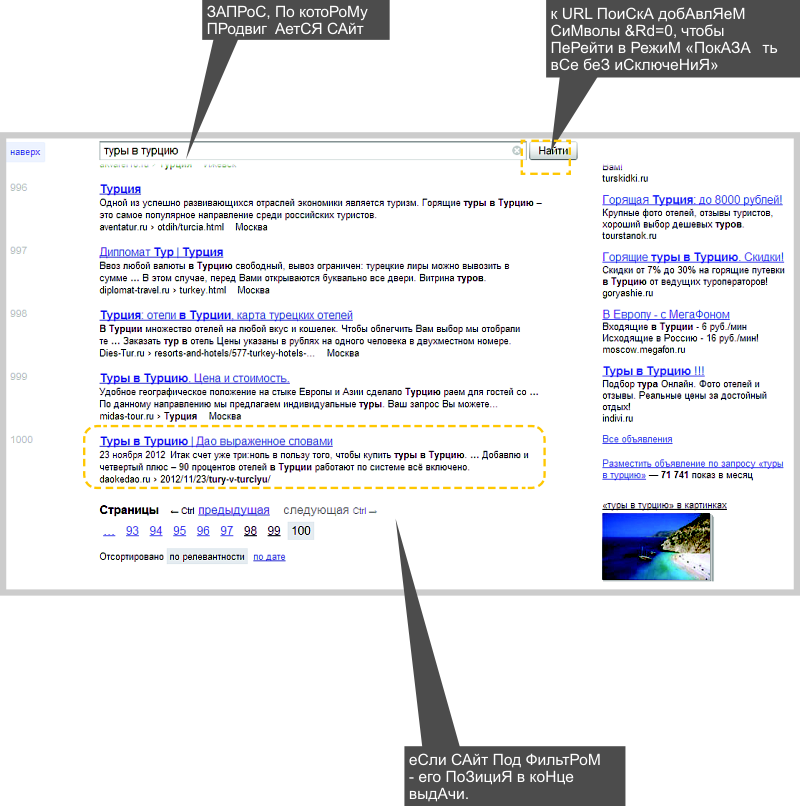

Обнаружить данный фильтр можно, введя в строку поиска точную фразу со страницы и проанализировав позиции ресурса по ней в выдаче ПС. Если сайта нет, а в режиме «Показать все без исключения» он присутствует на самой последней странице, то вы столкнулись с фильтром «Ты последний».

Порядок действий по снятию фильтра «Ты последний»

Рис.3 Пример сайта, который попал под фильтр "Ты последний"

- «Ты спамный»

«Ты спамный» — фильтр, который накладывается на сайт за некачественный контент. После наложения этого фильтра продвигаемая страница резко теряет позиции по определенному ключевому запросу.

Какие тексты Яндекс признает некачественными:

- объемные (больше 4000 слов), перенасыщенные ключевыми словами (если их плотность составляет более 10% от всего текста);

- с чрезмерным выделением курсивом;

- где присутствует подчеркивание и чрезмерное использование жирного шрифта для ключевых фраз;

- где можно увидеть неестественные сочетания слов, противоречащие правилам русского языка, и т.д.

Такой контент написан больше для поисковых роботов, а людям воспринимать его неудобно.

Рис.4 Пример переоптимизированного контента

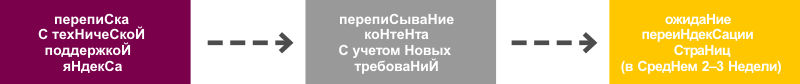

Порядок действий по снятию фильтра «Ты спамный»

После получения ответа с подтверждением о применении санкций необходимо устранить все замечания и сделать текст интересным для чтения, сократить плотность ключевых слов до 5-7%, равномерно распределить их по всей странице и не увлекаться использованием разных шрифтов.

Если все исправлено, после полной переиндексации позиции восстановятся. Согласно информационному сообщению Яндекса, срок ожидания может составить от 2 до 3 недель (цифра действительна на июль 2012).

- «Ссылочный взрыв»

«Ссылочный взрыв» — фильтр, который накладывается на сайт–акцептор за резкое увеличение количества ведущих на него ссылок.

Определить, что сайт оказался под действием именно «ссылочного взрыва», достаточно сложно. Основные признаки: отсутствие динамики продвижения даже по низкочастотным запросам на протяжении более 2 месяцев, как бы много ссылок вы ни закупали.

Быстро устранить последствия «ссылочного взрыва» невозможно. Поможет только переход от интенсивной к осторожной, взвешенной закупке ссылок и время: от 3 до 6 месяцев.

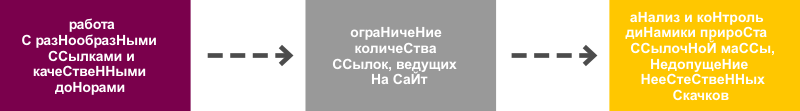

Порядок действий по снятию фильтра «Ссылочный взрыв»:

Вы не попадете под этот фильтр, если продвигаете свой ресурс с помощью

сервиса Rookee: система автоматически определяет оптимальное количество ссылок для закупки.

- Непот-фильтр

Непот — это фильтр, который накладывается на страницы, участвующие в продаже мест под ссылки. В результате закупленные на этих страницах ссылки теряют свой вес. Среди главных причин наложения фильтра можно выделить следующие:

- множество исходящих ссылок с одной страницы (ссылочный спам). Формально сайт начинает рисковать, если количество таких ссылок превышает 5. Как правило, фильтр накладывается, если на странице

больше 25 ссылок;

- немодерируемая продажа ссылочных мест (размещение практически на всех страницах сайта любого количества нетематических ссылок).

Несмотря на то, что непот-фильтр накладывается на страницы доноров, пострадают и сайты-акцепторы. Некачественная площадка не будет приводить новых клиентов и повышать позиции сайта в поисковой выдаче. Поэтому владельцу сайта-акцептора следует предъявлять жесткие требования к площадкам для размещения ссылки, а владельцу сайта-донора — к устанавливаемым ссылкам.

Порядок действий по снятию фильтра «Непот-фильтр»:

- Фильтр за накрутку поведенческих факторов

Поведенческая накрутка — это фильтр, который накладывается на сайт за попытку повлиять на позиции в поисковой выдаче путем манипуляции действиями пользователей.

При ранжировании Яндекс учитывает поведенческие факторы, такие как показатель отказов (сколько пользователей перешли на сайт и сразу же ушли), время пребывания на сайте, количество просмотренных страниц, возвращение пользователя к поисковику и многие другие.

Если сайт качественный, то пользователи смотрят несколько страниц (3 и более), проводят на сайте больше одной минуты и т.д. Такой сайт поисковая система оценивает как полезный и поднимает в поисковой выдаче.

Чтобы добиться таких показателей, необходимо постоянно улучшать и оптимизировать сайт, а это занимает время. Некоторые владельцы сайтов пытаются обмануть поисковую систему и накручивают показатели искусственно, когда специально нанятые люди или роботы выполняют конкретные действия по сценарию: например, зашли на сайт, просмотрели 10 определенных страниц, провели на нем 10 минут.

Основной признак попадания под фильтр — резкое падение позиций практически всех страниц после апдейта.

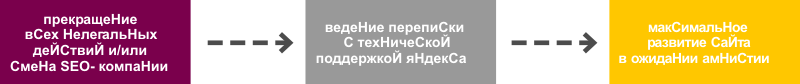

Для подтверждения того факта, что сайт попал под фильтр за манипуляцию действиями пользователей, нужно обратиться в техническую поддержку Яндекса.

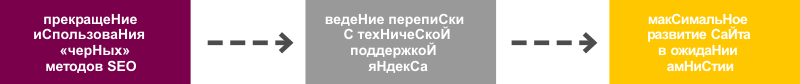

Попав под фильтр, необходимо прекратить поведенческую накрутку и направить свои действия на естественное продвижение сайта. Ускорить снятие данной санкции нельзя, необходимо ждать, когда произойдет апдейт — от двух недель до полутора месяцев. До этого момента важно максимально полно подготовить ресурс, и тогда после обновления он займет прежние позиции.

Порядок действий по снятию фильтра «Поведенческая накрутка»:

Для того чтобы не попасть под данный фильтр, необходимо придерживаться следующих рекомендаций:

- не накручивайте поведенческие факторы;

прежде чем поручить свой сайт специалисту по SEO, уточните у него, использует ли он методы «черного SEO», и если ответ — «Да», то с таким сотрудником лучше не работать.

- если накрутка является результатом действий конкурентов, то как можно быстрее предупредите об этом специалистов Яндекса.

Чтобы своевременно замечать и пресекать такие действия, необходимо систематически проводить мониторинг с помощью систем сбора статистики Яндекс.Метрика или Google Analytics. В случае, если вы обнаружили ничем не объяснимые результаты (предположим, внезапно выросло количество отказов или наоборот, этот показатель неестественно улучшился), следует сообщить в службу поддержки поисковой системы о возможных нарушениях со стороны недоброжелателей.

На какие параметры рекомендуется обращать внимание:

- CTR переходов на сайт через поисковые системы (можно посмотреть в Яндекс.Вебмастер);

- показатели посещаемости сайта: трафик, количество просмотренных страниц, новых посетителей и др.;

- показатель отказов и время, проведенное пользователем на сайте.

- переходы на сайт из закладок, почты, социальных сетей и других источников за исключением поиска;

- характеристики пользователей: город, IP, время посещения, версии браузеров, анализ поведения через Вебвизор, специальный инструмент Яндекс.Метрики.

- Аффилиат-фильтр

Аффилиаты — это группа сайтов одного владельца и одной тематики, направленные на монополизацию первой страницы результатов поиска.

Аффилиат-фильтр — это санкция, которая сильно занижает позиции всех сайтов группы аффилиатов, за исключением наиболее релевантного.

Чаще всего данный фильтр накладывается автоматически с помощью алгоритма. Но возможно наложение и в ручном режиме после жалобы конкурентов.

По каким критериям поисковая система вычисляет сайты-аффилиаты:

- одинаковые контактные данные на сайтах (телефон, e-mail, название компании);

- схожесть доменных имен, названий компаний, логотипов;

- схожесть дизайна или структуры сайта;

- скопированная или похожая информация на разных сайтах;

- одинаковый каталог услуг или товаров;

- один прайс-лист;

- один хостинг;

- наличие комбинированных данных с разных ресурсов (например, указан адрес, встречающийся на одном сайте, а телефон — на другом);

- переадресация телефонного звонка с разных номеров на одну компанию (выявляется при ручной проверке).

Поводом для того, чтобы система тщательно проверила сайты на наличие аффилиатов, могут быть пересекающиеся аккаунты систем статистики (например, в Яндекс.Метрике), размещения контекстной рекламы (Яндекс.Директ), вспомогательных инструментов (Яндекс.Вебмастер).

Иногда поисковая система может принять за аффилиаты неоптимизированые сайты, где некорректно настроен редирект, либо сайты одной компании различной тематики, где дублируется одна и та же общая информация (к примеру, контактные данные).

Если ваш сайт попал под аффилиат-фильтр, то на возвращение в ТОП потребуется несколько месяцев и частая переписка со службой поддержки Яндекса. Чтобы не попасть под этот фильтр, следует соблюдать следующие правила:

- Закрыть сайты-аффилиаты от индексации или сделать их неосновными зеркалами продвигаемого ресурса.

- Изменить один из аффилиатов так, чтобы сайты относились к разным направлениям деятельности и продвигались по разным запросам.

Выбор одного из вышеперечисленных вариантов зависит от многих факторов: ограничений на сайте, возможностей SEO-специалиста, требований владельца ресурса.

Фильтры Google

Фильтры Яндекса и Google основаны на общих принципах и в целом похожи. Подробно нарушения, за которые Google пессимизирует сайты, описаны в правилах Google для вебмастеров — на английском. Ниже вы познакомитесь с обзором этих санкций и способами выйти из-под них.

Поисковые системы постоянно обновляют фильтры и вводят новые. Чтобы всегда быть в курсе последних изменений и знать лучшие тактики по возвращению сайтов в ТОП, рекомендуем следить за новостями в блоге системы автоматизированного продвижения сайтов Rookee и на портале SeoNews.

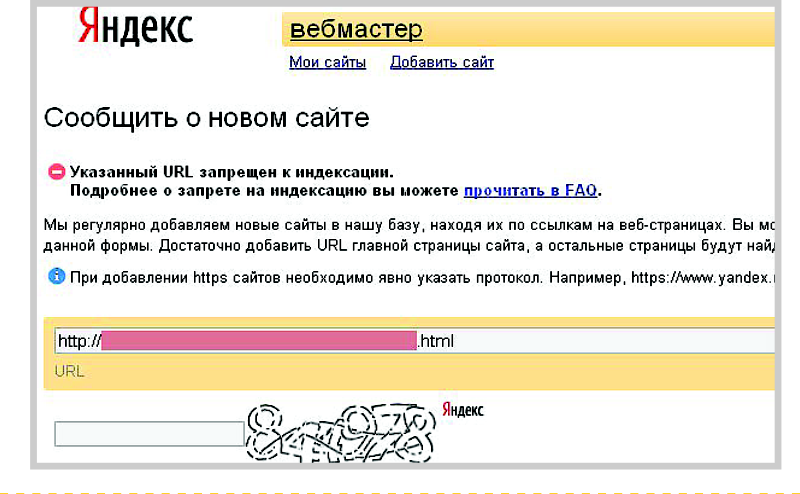

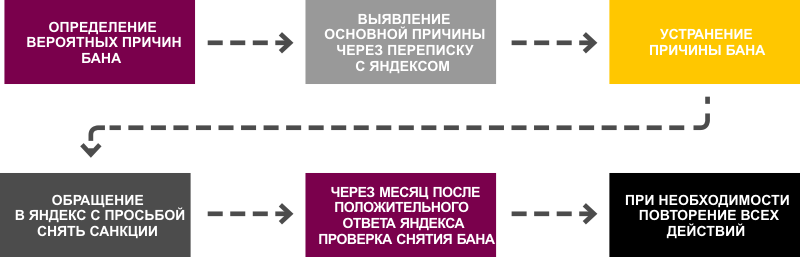

Бан сайта

Бан — это запрет на индексирование сайта, самая жесткая санкция поисковой системы. Накладывается на сайт в случае, если на нем обнаружено большое количество нарушений. Под баном можно провести от 4-х месяцев до 1 года.

Рассмотрим эту санкцию на примере поисковой системы Яндекс. Если на сайт наложен бан, то в индексе поисковой системы нет ни одной страницы ресурса, а при добавлении его адреса на панель Яндекс.Вебмастер выдается сообщение «запрещен к индексации».

Рис.5 Пример сообщения в панели Яндекс.Вебмастер о том, что на сайт наложен бан

Заниматься продвижением такого сайта бесполезно. Чтобы бы вы ни делали, поисковые системы все равно не будут показывать его в естественной выдаче. Прежде необходимо снять запрет на индексирование, что является долгой и трудоемкой задачей.

Вот так нужно действовать, если на ваш сайт наложен бан:

Чтобы написать в техподдержку, надо войти в Яндекс.Вебмастер под тем аккаунтом, на который зарегистрирован ресурс. Попав в систему, следует перейти по ссылке «Задать вопрос о сайте службе поддержки».

Процесс выхода из-под бана может занять много месяцев, и даже после возвращения в индекс сайту будет сложно поднять свои позиции, поскольку репутация ресурса испорчена. Зачастую бывает проще запустить сайт на новом домене и не повторять ошибок.

Влияние хостинга на продвижение сайта

Хостинг — это физическое пространство на удаленном сервере, которое должно всегда находиться в сети для непрерывного функционирования сайта.

Основным параметром хостинга, влияющим на продвижение, является аптайм — время работы ресурса в нормальном режиме. Аптайм должен быть близок к 100%. Например, при показателе 99% ресурс находится в нерабочем состоянии 1 минуту из 100. Считается, что наилучший показатель — это 99,98%.

Если в то время, пока сайт был недоступен, на него пытался зайти робот и не нашел его, то потом долгое время сайт не будет индексироваться. Его позиции в поисковой выдаче не будут улучшаться.

Важными являются и параметры сервера, выделенные конкретному пользователю и конкретному сайту, например, приоритет использования процессора, процент доступной оперативной памяти, дисковое пространство.

Параметры хостинга могут повлиять на масштабность проекта. Если сайт посещают 10-50 человек в день и на нем отсутствуют сложные скрипты, можно выбрать простую конфигурацию и недорогой тариф. Если говорить о крупном портале, малая мощность сервера может привести к медленной работе сайта, зависаниям и другим ошибкам. Поэтому оптимальным вариантом будет выбор виртуального (VDS, VPS) или физического выделенного сервера (dedicated server). Однако в таком случае стоимость хостинга будет выше.

Степень доверия поисковой системы к компании-провайдеру и, как следствие, к ресурсам, расположенным на ее серверах, также оказывает влияние на поисковое продвижение. При выборе партнера, предоставляющего услуги хостинга, лучше остановиться на сотрудничестве с крупной организацией. Так вы сможете получить более качественную техническую поддержку и свести к минимуму вероятность заражения сайта вирусами.

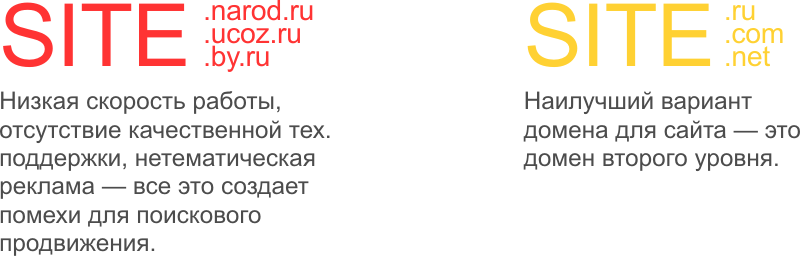

Влияние доменного имени на продвижение сайта

Доменное имя — это название сайта, его идентификатор для поисковой системы. Лучше выбирать доменное имя второго уровня — это часть, отделенная точкой от домена первого уровня, то есть от .ru, .com, .net, .info и т.д. Например, в http: //promo.ingate.ru/ часть «ingate» является доменом второго уровня, promo — доменом третьего уровня.

Поисковые роботы отдают предпочтение доменам второго уровня.

Один из способов вывода сайта в ТОП поисковой выдачи — наличие в доменном имени основного высокочастотного запроса. Наибольший эффект заметен при использовании англоязычных запросов, для русских слов можно применить транслитное написание. Например, для компании, занимающейся продажей пластиковых окон в Москве, таким доменом может быть Mosokna.ru.

Лучше использовать короткое доменное имя. Во-первых, оно быстрее запоминается. Во-вторых, слишком длинные домены с вхождением нескольких ключевых слов могут быть восприняты поисковыми системами как спам.

Например, удачным для продвижения можно считать название сайта www.seo.ru, а вот «переоптимизированный» домен seo-pr0dvijenie-moskve-promo.ru поисковые системы могут принять за спам.

Регистрировать права на домен следует на клиента, заказывающего продвижение, либо на исполнителя — это позволит избежать блокировки неавторизованных или неоплаченных доменов.

Для рунета самым оптимальным вариантом является использование доменной зоны .RU. По ней можно сразу определить принадлежность сайта к российскому сегменту интернета.

В конце 2009 года появился национальный кириллический домен верхнего уровня — .РФ. Особенность использования данной зоны заключается в том, что название сайта пишется исключительно кириллицей. Преимуществом этого является возможность включать прямые вхождения ключевых слов в домен.

Однако при работе с доменами в зоне .РФ существует ряд ограничений:

- Большинство веб-сервисов и ряд систем управления сайтами (CMS) не поддерживают кириллические домены. В таких случаях для преобразования адресов требуется конвертер, который затрудняет работу

тех же поисковых систем.

- Аудитория сайта может жить за пределами Российской Федерации. Тогда пользователям будут необходимы навыки владения виртуальной клавиатурой или сервисом декодирования кириллицы. Например, адрес страницы http: //яр-мебель.рф/page/faq/ после преобразования конвертером будет выглядеть так: http: //xn----btblb4ac0a6hta.xn--p1ai/page/faq/

- RSS-рассылку с вашего сайта смогут получить не все пользователи, т.к. некоторые RSS-агрегаторы не воспринимают сайты на кириллическом домене. Одно из самых простых решений для пользователя — это сменить RSS-reader.

- Возможны неудобства для пользователей, которые по привычке будут использовать латинские буквы.

Официальные представители Яндекса утверждают, что с точки зрения поисковой оптимизации домены .RU и .РФ одинаковы, однако опыт SEO-компаний показывает, что вывести в ТОП сайт, размещенный в доменной зоне .РФ, гораздо сложнее.

Система управления контентом (CMS)

Система управления контентом (CMS, от англ. Content management System) — это комплекс решений, на базе которого создается и администрируется ресурс.

Сайт-визитка может обойтись и без CMS, но для регулярного обновления информации на большом серьезном ресурсе наличие системы управления контентом необходимо. Если рассматривать характеристики CMS с точки зрения поисковой оптимизации, то можно выделить ряд требований к ним:

- корректность формирования адресов страниц сайта;

Многие CMS формируют URL в динамическом виде, создают множество дублей, уровней вложенности, что весьма негативно сказывается на поисковом продвижении и удобстве навигации по ресурсу.

- корректность формирования структуры сайта;

Далеко не все CMS способны сформировать структуру сайта правильно (с точки зрения SEO). Могут быть дублированные страницы, ссылки, которые никуда не ведут. В таких случаях затрудняется навигация по сайту, и ему самому присваиваются низкие значения тИЦ и Page Rank.

- возможность добавления в CMS дополнительных модулей;

Большинство современных систем позволяют без особых усилий создать блок новостей, статей и так далее.

- корректность взаимодействия с роботами поисковых систем;

CMS не должна блокировать их активность. Оптимальным решением будет выбор системы, уже имеющей проработанный robots.txt (файл, отвечающий за ограничение доступа поискового робота к определнной информации на сайте) и способной самостоятельно формировать корректный sitemap.xml (файл, представляющий собой карту сайта для поисковой системы).

- корректность работы с хостингом.

Некоторые (в основном некоммерческие) CMS могут создавать неоправданно большую нагрузку на оборудование хостера (провайдера) за счет неправильной организации внутренней структуры сайта, создания ненужных дублей страниц и т.д. В конечном итоге сайт может медленно грузиться.

Возраст сайта

Возраст сайта — это срок начала индексирования его страниц роботами поисковой системы. Для поисковой системы возраст ресурса и возраст домена — разные временные промежутки, но в большинстве случаев они совпадают.

Продвижение нового сайта (возраст до 1 года) потребует постепенного наращивания ссылочной массы, кропотливой работы по подбору качественных площадок и созданию полезных текстовых материалов. Заработать хорошие позиции по высокочастотным запросам молодым ресурсам практически невозможно. Их владельцам лучше не прибегать к агрессивной закупке ссылок, то есть не покупать больше 30-50 ссылок в месяц в первые полгода существования сайта и больше 70-80 ссылок в последующие 6-12 месяцев работы сайта.

Для закупки правильного количества ссылок и размещения их на качественных площадках существует система автоматизированного провижения сайтов Rookee.

Малый объем проиндексированных страниц

Если на сайте меньше 20 страниц, то продвигаемая по ключевому запросу страница не получит достаточного количества внутренних ссылок, следовательно, потребуются дополнительные расходы на наращивание ссылочной массы.

Необходимо постоянно увеличивать количество страниц и объем полезного контента на сайте. Учтите: если на сайте 100 страниц, а полезную информацию содержат только 20 из них, остальные страницы поисковая система не проиндексирует, посчитав их неинформативными.

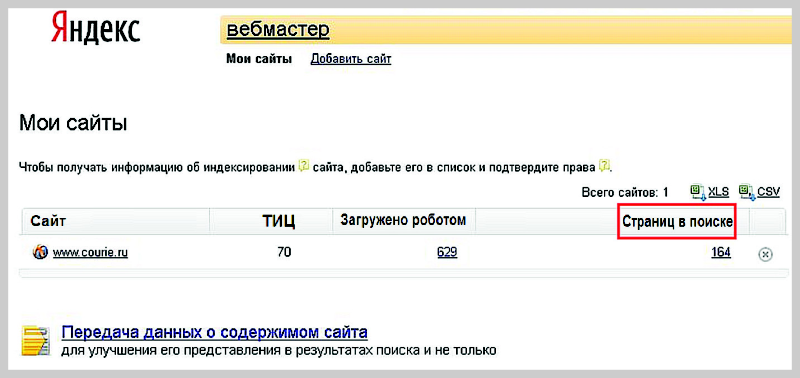

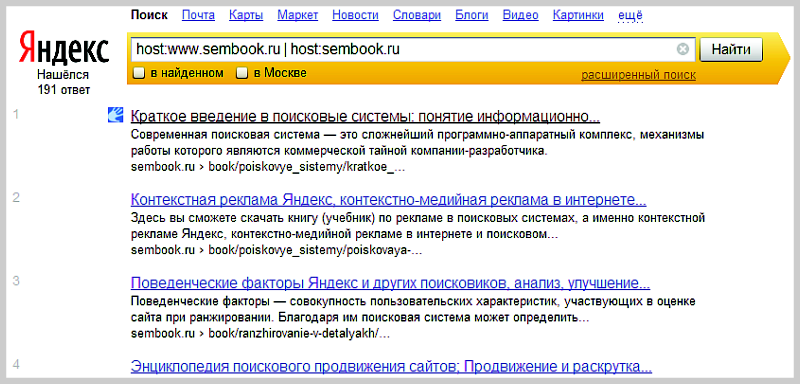

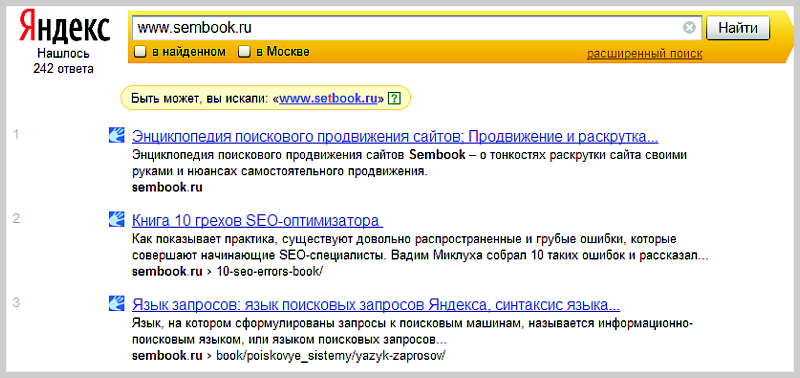

При принятии решения о продвижении ресурса обязательно оцените количество страниц в индексе и сравните его с общим числом страниц на сайте. Это можно сделать по средствам Яндекс.Вебмастера, расширенного поиска или с помощью языка запроса.

Рис.6 Определение количества страниц в индексе с помощью панели Яндекс.Вебмастер

Рис.7 Определение количества страниц в индексе с помощью поиска через host

Рис.8 Определение количества страниц в индексе с помощью режима расширенного поиска

Неуникальность контента

Контент — важная часть каждой страницы как для посетителя сайта, так и для поискового робота. Основной задачей поисковых систем является предоставление пользователю новой, полезной и уникальной информации, поэтому использование заимствованного контента является серьезным ограничением для продвижения.

В некоторых случаях можно просто закрыть страницу или заимствованную информацию от индексации с помощью тега «noindex», но злоупотреблять этим не стоит, так как поисковая система может расценить его частое использование как спам. Также при закрытии большого количества страниц можно резко сократить общую релевантность сайта запросу.

Самый идеальный вариант наполнения ресурса — создание собственного контента. Но даже в этом случае ресурс не застрахован от попадания под санкции за неуникальное содержание. Такое случается, когда кто-то копирует оригинальные статьи, и поисковые роботы индексируют сайт захватчика вперед оригинала. Чтобы этого не происходило, есть специальные механизмы, не позволяющие копировать контент через интерфейс. Если же воры все-таки украли информацию через код страницы и разместили у себя, необходимо требовать у них размещения копирайтов и ссылки на ваш сайт. В противном случае следует срочно пожаловаться в службу поддержки Яндекса.

Региональность сайта

Географическая принадлежность ресурса важна при поиске с ограничением по региону, когда установлена галочка в соответствующем поле под поисковой строкой (например, «в Москве», «в Екатеринбурге», т.д.). В этом случае сайты из других городов не принимают участие в ранжировании и, следовательно, не отображаются в результатах поисковой выдачи.

К сожалению, бывают случаи, когда сайт продвигается не по тому региону, к которому принадлежит, а официального адреса по продвигаемому региону компания не имеет. Это негативно сказывается на продвижении геозависимых запросов.

Последствиями того, что ресурс не принадлежит какому-либо региону, могут быть низкая конверсия и увеличение расходов на дополнительное развитие сайта. Закупка ссылок с ресурсов соответствующего региона, работа с анкорами (прописывание в них региона) и наполнение сайта полезной информацией — все это потребует немало времени, и, как следствие, больших сроков для вывода запросов в ТОП.

Запросы семантического ядра не соответствуют тематике сайта

Семантическое ядро — это список запросов, которые используются для продвижения сайта в поисковых системах.

При выборе запросов следует очень внимательно следить за их тематикой. Чем выше релевантность всего сайта тематике продвигаемого запроса, тем больше шансов занять первые позиции в поисковой выдаче. При добавлении новых страниц для продвижения нетематичного запроса возможно ухудшение позиций по изначально тематичным запросам. Например, если на сайте автомобилей начать активно продвигать страницу с кредитами (которые на самом деле не предлагает автомобильная компания), можно «заработать» пессимизацию.

Большое количество запросов для продвижения

Семантическое ядро, состоящее из нескольких сотен или даже тысяч запросов, значительно увеличивает сроки продвижения сайта. Вот основные причины:

- Закупка ссылок. Роботы поисковых систем негативно относятся к быстрому росту ссылочной массы, поэтому закупка ссылок не должна быть агрессивной. Чтобы набрать достаточное их количество для каждого запроса, потребуется значительно больше времени, чем при работе с семантическим ядром, состоящим, например, из 20-30 запросов.

- Написание и корректировка текста для продвигаемых страниц. Чем больше запросов, тем больше страниц с уникальным и полезным контентом под них нужно создать, что скажется на сроках оптимизации сайта.

- Внутренняя перелинковка. Потребуется много времени, чтобы корректно, в полном объёме и для необходимого количества запросов сделать перелинковку страниц сайта.

- Анализ конкурентов. При большом семантическом ядре необходимо

определить конкурентность большого числа запросов, и проводить такой анализ надо будет после каждого апдейта.

Большое количество ВЧ запросов

Не стоит ожидать значительного увеличения трафика в начале продвижения, если семантическое ядро состоит только из высокочастотных (ВЧ) и не содержит низкочастотных (НЧ) запросов. Это большая ошибка, поскольку обычно НЧ запросы гораздо быстрее попадают в ТОП поисковой выдачи и практически сразу начинают приводить первых посетителей.

Среди основных недостатков продвижения большого количества высокочастотных запросов можно выделить:

- Приток нецелевых посетителей. Высокочастотные запросы не являются точными. Попав на сайт из результатов выдачи по такому запросу и не найдя нужной информации, пользователь возвращается обратно в поиск. Следовательно, значительная часть денег на ВЧ продвижение будет потрачена зря, а у вашего сайта ухудшится статистика поведенческих факторов за счет того, что увеличится показатель отказов.

- Высокая конкуренция. Высокочастотные запросы часто являются высококонкурентными, продвижение которых требует больших денежных вложений и сил на последующее удержание позиций.

- Ограничения в выборе продвигаемой страницы. Как правило, для продвижения под высокочастотные запросы выбирают главную страницу сайта (ее вес обычно выше из-за естественной ссылочной массы и

организованной перелинковки).